会員インタビュー 量子分野の未来はハードウェアの再評価と異業種連携にかかっている

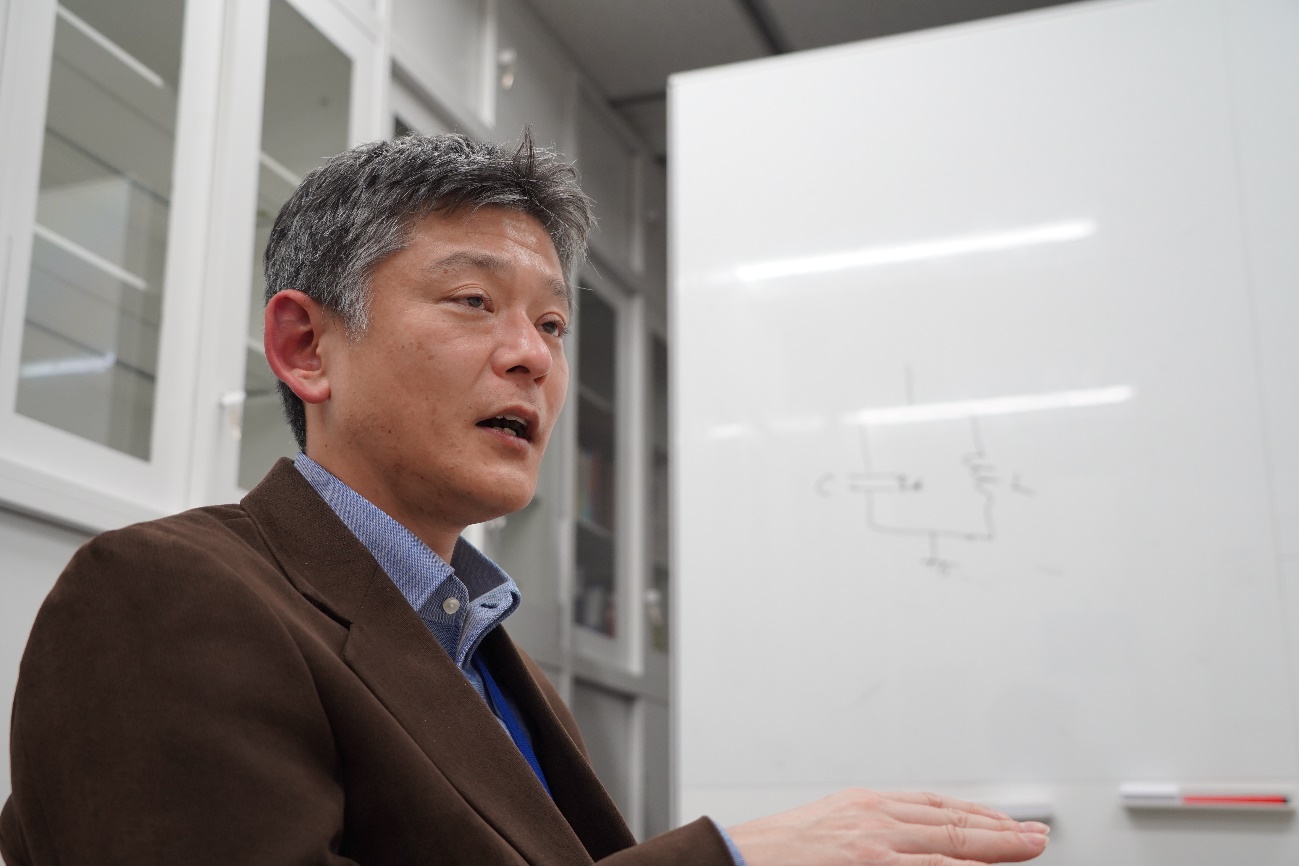

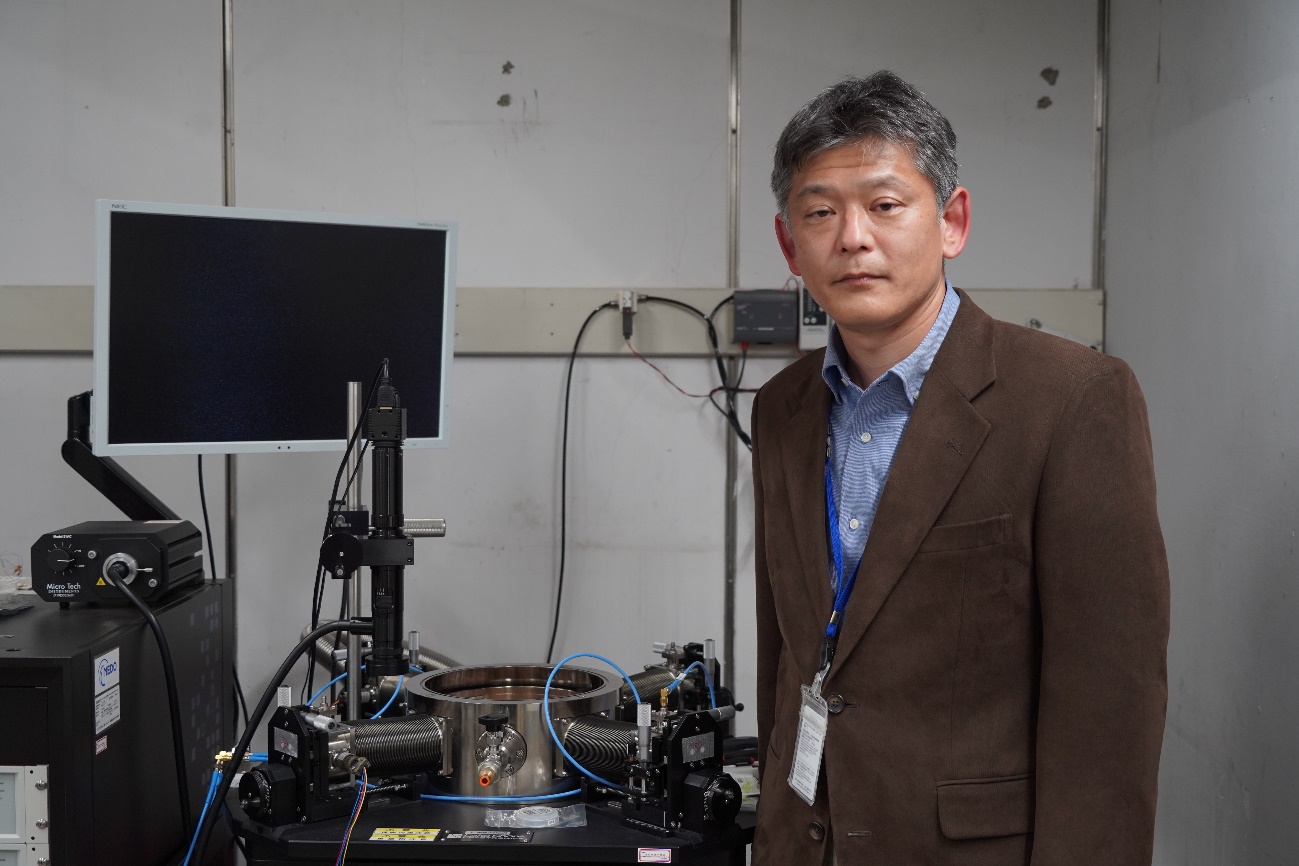

日本電気株式会社 システムプラットフォーム研究所 山本 剛

量子コンピュータが世界で注目されるようになった契機は、2011年、カナダのD-Wave Systems社による商品化であろう。Googleによる2014年の独自開発の発表と、2019年の量子超越性(従来型スーパーコンピュータを超えた計算能力)の実証も大きなインパクトを与えた。

実は、こういった量子コンピュータの技術開発には、日本も大きく貢献している。

1999年、日本電気株式会社(NEC)の中村泰信(現・理化学研究所量子コンピュータ研究センター・センター長、東京大学教授)、蔡兆申(現・東京理科大学教授)らが世界で初めて超伝導量子ビットの1ビット動作を実現した。さらに2003年には、やはり固体素子として世界で初めて超伝導量子ビットの2ビットゲート動作を実証し、超伝導量子計算の万能ゲートを実現した。また2008年には、のちに業界の主流方式となる量子ビットの分散読み出しにおけるキーデバイスの動作実証に世界に先駆けて成功した。これらの研究成果は量子コンピュータの社会実装へと道筋を付ける大きな一歩であるといえよう。

(取材・撮影:加藤俊/構成:小林浩)

<目次>

そもそも超伝導量子ビットとは何か?

量子コンピュータを実現するためには量子ビットが必要である。その量子ビットを実現するための物理系(ハードウェア)には、イオン、光、半導体など、幾つかの物理系が候補として挙げられている。その中で、今、最も注目されている物理系の一つが超伝導回路である。超伝導量子ビットとは、超伝導回路を利用して実現される量子ビットである。

超伝導とは、特定の物質を冷却していくとある温度以下で電気抵抗がゼロになる現象だ。したがって、超伝導量子ビットを動作させるには強力な冷却装置が必要となる。現在、最もよく使われているものが希釈冷凍機だ。10mK(ミリケルビン)程度まで冷やすことができる。絶対零度は-273.15℃であるが、それよりも0.01℃だけ高い温度が10mKだ。

到達温度は低いほどよいのであるが、冷凍機の冷凍能力と外から少しずつ入ってくる熱とのせめぎ合いで平衡点に達する。その温度が今は10mKとなっている。1mK以下まで温度を低くできる冷凍機も存在するが、希釈冷凍機と比べると試料スペースが小さく、また超伝導量子ビットとは相性の悪い強磁場が必要といったデメリットがある。

現在の希釈冷凍機は、数10cmスケールの試料空間を10mKまで永続的に冷やすことが可能だ。むろん、試料空間の拡大や冷凍能力の向上といった課題があるものの、今のところ超伝導量子ビットを用いた量子コンピュータにとって最適な冷凍機である。

従来型コンピュータの中では、CPU(中央処理装置)が計算を行うための作業領域として、DRAM(動的ランダムアクセスメモリー)に情報を保持する役割を担わせている。DRAMのビット1つは、単純な構造できている。金属とシリコン基板が2つの電極をなし、絶縁体を挟んで向き合った、いわゆるコンデンサー(キャパシタ)になっている。そこに電圧をかけることによってそれぞれが帯電する。帯電しているかどうかによって0と1の情報を保持することになる。

超伝導量子ビットの場合は、2つの電極が超伝導物質で作られている。そして、その2つの電極がジョセフソン接合という構造で結合されている。量子ビットは従来型のビットとは異なり、量子力学的に0と1の重ね合わせという状態(量子重ね合わせ)を取ることができる。この状態をうまく計算に利用することによって、従来型コンピュータよりも桁違いに速い計算能力を有する量子コンピュータが実現可能となる。

1999年、この仕組みの量子ビットを世界で初めて実現したのが、当時NECにいた中村と蔡である。イオンや核スピンといったミクロな系ではなく、超伝導回路というマクロな人工物において、量子力学が予言する重ね合わせ状態が実現することを明確に示した彼らの結果は、量子物理の学会に非常に大きなインパクトを与えた。同時に量子コンピュータが実現できるかもしれないとの期待から世界中のグループを巻き込む熾烈な開発競争の幕開けとなった。NECのチームも、理化学研究所と協力して、1999年の成果を発展させるべく研究開発に取り組み、2ビットゲートの実証や量子ビットデコヒーレンスに関する系統的調査、量子ビット読み出しのためのパラメトリック増幅器の開発などの成果により、黎明期における超伝導量子ビットの発展を牽引した。そのNEC、理研チームにおいて、中心的な役割を果たした一人が山本である。

報告されている論文でも間違っていることがある

このように量子コンピュータ技術の開発に貢献した山本だが、もともと物理が得意というわけではなかった。兵庫県神戸市に生まれ、自然豊かな環境で育った。少年時代は野球などをして外で遊ぶことが好きだったと山本は言う。

東京大学理科一類に進学し、1年半の教養課程の後、後期課程の専門学科を決めることになるが、初めは化学の道に進もうと思っていた。理由は、高校では物理よりは化学のほうが好きで有機合成などに興味があったからだ。しかし、大学では化学の授業がよく分からなかった。化学に比べて物理学の授業は、少しは理解できたことから、工学部物理工学科を選ぶことにした。

大学3年生のときに、高温超伝導体の試料を作り、電気抵抗の温度依存性を測定する実験があった。実際に自分が粉を混ぜて焼いて作った試料を液体窒素温度(-196℃)付近まで冷却すると電気抵抗がゼロになることに衝撃を受け、高温超伝導について研究をする為ヶ井強先生の研究室に入ることにした。

修士課程からは、内野倉國光先生の下で高温超伝導体の関連物質を薄膜で作る研究をし、修士論文を書いた。それをさらに深めようと博士課程に進学したのだが、研究は思うようには進まなかった。その物質について電気伝導率等の物性を調べていたのだが、そもそもそれまで信じられていたその物質の結晶構造では、組成分析やX線回折等の結果にいろいろと不自然な点があった。修士課程のときはまさか報告されている論文の内容が間違えているとは疑わなかったのだが、博士課程ではきちんと結晶構造を調べないと駄目なのではないかと思うようになった。

すっきりしないまま研究を続け、気が付くと博士課程2年の夏になっていた。あるとき、為ヶ井先生に相談し、「きちんと結晶構造を調べないと物性の議論はできない」と言われて踏ん切りがついた。もう博士課程の半分近くが経過してしまったのだが、自分でもはっきりさせるべきだと思ったので、そこから全部リセットをした。薄膜をやめて、バルクを使って結晶構造を調べることにした。

後から分かるのだが、その物質は単純には解けない複雑で面白い構造を持っていた。専門家の協力も得て結晶構造を解析しようとしたのだが、それでもなかなか解けなかった。ただし、「やはり論文とは違う」ということは徐々に確信を深めていった。そうしているところに、自分の薄膜の論文を読んだフランスの研究グループから、幾つかの論文が送られてきた。彼らは「われわれはこういうことをやっている」という研究の紹介をしてきたのだが、幸いなことにそれが大きなヒントとなった。

結局、それまで信じられていた結晶構造は間違っていた。つまり修士課程で参照した論文は間違っていたのだ。報告されている論文でも間違っていることがあるということを、強烈にそこで印象付けられた。今考えればそれほど驚くことではないかもしれないが、学生時代にそのようなことを身をもって経験したことは、自分にとっては大変プラスとなった。

結晶構造の問題が解決した後は、ひたすらその物質の物性評価を行った。幸運にも判明した結晶構造は、物性的にも大変興味深い構造であった。その結晶構造をベースに物性データの解釈を再検討し、博士論文にまとめた。今思えば、ぎりぎりで卒業したという感じだった。

NECに入社してから始めた超伝導量子ビットの研究

山本は、自分が生み出したものを世の中に出したいという気持ちが強かったため、卒業後は企業で研究したいと思っていた。だが、量子コンピュータに関わろうという考えは、もともとは持っておらず、専門にしてきた物性の知識が生かせる企業での研究職を探していた。

NECにもそのような希望職種で応募したのだが、空きがないということで一度は断られた。しかし後日、NECの蔡のグループが研究者を募集しているという話があり、再び面接を受けることになった。

中村が2001年にオランダのデルフト工科大学に留学することになっていたため、その間グループとしての研究ペースを落とさないために、人材を探していたのだ。たまたまそのタイミングに山本が巡り合ったというわけである。

山本は中村と蔡が超伝導量子ビットの動作に成功した1999年にはまだNECにいなかった。山本は超伝導や物性物理の出身ではあったが、超伝導量子ビットの研究はNECに入社した2001年から始めたことになる。今回、超伝導量子ビットとの出会いから約20年の軌跡を、山本に詳しく語ってもらった。

量子コンピュータを実現するための条件、「DiVincenzoのクライテリア」

―NECに入社して、どのような研究からスタートしたのか。

1999年に中村・蔡の両氏が成功したのは、1量子ビットの動作だ。私が2001年に入社してまずアサインされた仕事は、蔡氏をリーダとする理研とNECとの共同研究のチームにおいて、2量子ビットのゲート動作を実現するということだった。この仕事の重要性を理解するには、「DiVincenzoのクライテリア」というものを知らなければならない。

「DiVincenzoのクライテリア」とは、2000年に米国の理論物理学者David DiVincenzoがまとめた、量子コンピュータを構成する物理系に要求される条件のことだ。「拡張可能性」、「初期化能力」、「長いコヒーレンス時間」、「ユニバーサルゲートセット」、「読み出し能力」という5つの条件を量子ビットが満たさなければ、量子コンピュータは実現できないとされている。

この条件の中の一つであるユニバーサルゲートセットとは、計算万能性を意味する。ユニバーサルゲートセットが実現できれば、原理的にはどのような量子計算も実行できるということだ。そのためには、具体的に1量子ビットと2量子ビットのゲート動作を実現しなければならないのだ。

量子力学の表現では、1量子ビットの動作が「量子重ね合わせ」、2量子ビットの動作が「量子エンタングルメント」(「量子もつれ」や「量子絡み合い」ともいわれる)の実現を示している。「量子エンタングルメント」とは、空間的には離れている量子ビット間の量子状態が、あたかも1つの物体であるかのように関係し合うことで生まれる量子力学特有の効果だ。この2つの状態をうまく利用していくことで、量子コンピュータの高速な情報処理が可能となる。

1量子ビットの動作は、1999年に中村・蔡によって実現した。ユニバーサルゲートセットという条件のうちの半分ができたことになる。当然、次のステップは2量子ビットのゲートを動作させるということだ。それができればユニバーサルゲートセットという「DiVincenzoのクライテリア」の一つが達成されることになる。私が入社して任された仕事が、その2量子ビットのゲート動作を実現するということだった。それがうまくいって、2003年に論文として発表することができた。

―ユニバーサルゲートセットの次に手掛けた仕事は何か。

「DiVincenzoのクライテリア」のもう一つの条件である「読み出し能力」だ。これも量子コンピュータの重要な要素技術である。計算が終わった後やエラー訂正の際にいかに正確に量子ビットの状態を読み出すかということだ。

1999年の中村・蔡の研究の読み出し方法には課題があり、それを改善した新しい読み出し方法が当時いろいろ提案・実験されていた。そのうちの一つにマイクロ波を使った読み出し方法があり、米国のイェール大学のグループ等から実験が報告されていた。超伝導量子ビットとマイクロ波の光子を結び付けるサーキットQEDという研究分野が始まり出した頃で、非線形のマイクロ波共振器を使ったBifurcation amplifier(分岐増幅器)が報告されていた。

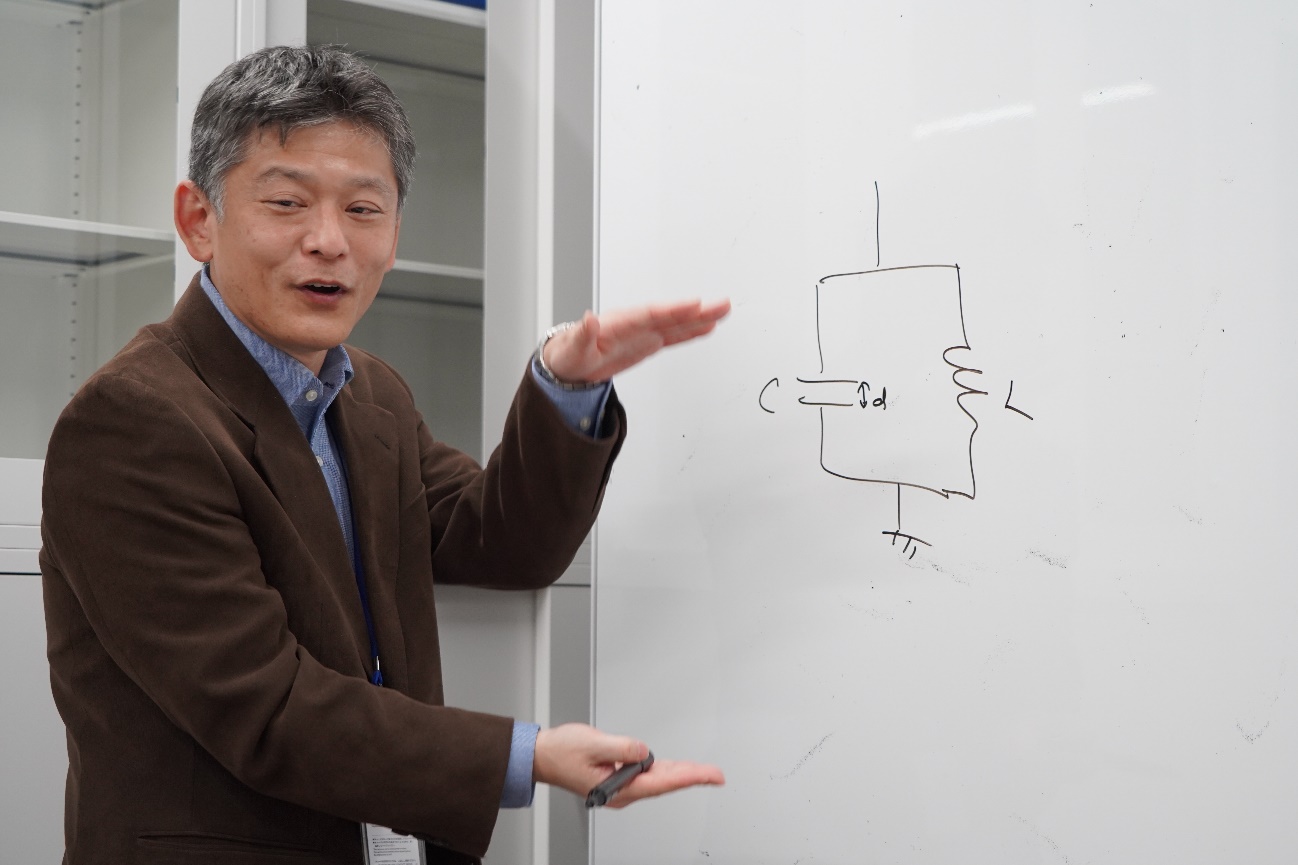

2006年頃から、われわれもBifurcation amplifierを用いた量子ビットの読み出しに取り組み始めた。普通の共振器はインダクタとキャパシタで構成されるが、インダクタの一部分をジョセフソン接合に置き換えた非線形共振器が示す分岐化現象を使って量子ビットを読み出そうとしていた。その研究課程において、パラメトリック増幅器というものに注目するようになった。

量子ビットの読み出し技術へのチャレンジ

―パラメトリック増幅とはどのようなものか。

パラメトリック増幅の原理は、ブランコをこいで振幅を大きくしていくことに似ている。

ブランコの振幅を大きくするには、振幅が一番高いところで立ち上がって重心を一番高くして、一番底に来たときに下にしゃがむ。また上に行ったときに立ち上がるという動作を繰り返していくと、どんどん振幅が大きくなる。

このようなブランコの運動を振り子としてモデル化すると、重心の上下に合わせて振り子の糸の長さを変えていることに相当する。振り子が一番下に来たときに糸を一番長くして、一番高いところでは短くする。要は、糸の長さというパラメータを時間的に変調しているのだ。

糸の長さを変える周期やタイミングをうまく選んでやると、この振幅はどんどん大きくなる。これをパラメータ共振という。これは教科書にも載っているような、よく知られた現象である。

一方、電気回路では、キャパシタの2つの電極がどれぐらい近いかでキャパシタンスが変わる。もし電極の距離を時間的に変えることができたら、ブランコと同じで増幅作用を生み出すことができる。この仕組みで成り立っているのがパラメトリック増幅器だ。これも非線形力学の教科書には当たり前のように書いてある。

当時私は分岐増幅器の研究を通じて、ジョセフソン接合を使うと非線形力学の分野で知られた現象を電気回路で実現できるということをようやく理解し始めていた。それで私は、同じ非線形力学の教科書に載っていたパラメータ共振に注目した。ジョセフソン接合を使ってパラメータ共振をやったら新しいのではないかと思った。

―その新しい試みはうまくいったのか。

私は新しいと思っていたのだが、調べてみると1970年代にすでに超伝導のパラメトリック増幅器が開発されていたということが分かり、これは駄目かと思った。しかし、昔のパラメトリック増幅器は、回路のパラメータを時間で変えているようには見えなかった。なぜこれをパラメータ増幅と呼ぶのかすら、最初は全然理解できなかった。

しばらくしてから分かったことだが、実はそれは磁束駆動型か電流駆動型かの違いだった。昔のものは電流駆動型で、われわれが開発しようとしていたのは磁束駆動型のパラメトリック増幅器だったのである。

やはりこれは新しい、過去に実証されているものではないという確信が得られたので、実験を行った。期待どおりの振る舞いを示し、アンプとして使えることが分かったので、2008年に論文として発表した。NEC・理研の研究チームで開発した最初のパラメトリック増幅器である。

―2014年の発表では「超伝導回路を用いてパラメトロンを実現した」とあった。パラメトロンとパラメトリック増幅器の違いは何なのか。

パラメトロンとは、そもそも1950年代に当時東京大学の大学院生であった後藤英一によって発明された論理素子である。2つのパラメトリック発振状態をビットとして用いている。

実は、NECはパラメトロン方式のデジタルコンピュータを1958年に商用化している。しかし、パラメトロンコンピュータは、トランジスタを使ったコンピュータの普及によって衰退していった。

―パラメトリック発振という用語が出てきたが、パラメトリック増幅との違いを教えてほしい。

パラメトリック増幅器は何のために開発したかというと、量子ビットの読み出しを効率的に行うためだ。超伝導量子ビットを読み出すために、とても微弱なマイクロ波を共振器に入れて、位相や振幅を読むということをしなければいけない。その微弱なマイクロ波を増幅するために極限的に低雑音のアンプが必要だった。

増幅器とは、信号の入力を受けて、それを大きくして出力するというものである。そのためには、パラメトリック増幅器の場合、振り子の糸を変調することに相当する外部からのエネルギーの供給が必要であるが、このエネルギーを一定以上に大きくすると、増幅器ではなくて発振器として動作することが知られている。そこで、われわれが作ったパラメトリック増幅器を、発振器という別の動作モードにしてみると、読み出しの効率がもっと上がるということが分かった。

つまり、パラメトリック発振器を使って量子ビットの読み出しをしたということである。これが2014年の仕事である。われわれが実現したデバイスは、いわば1950年代のパラメトロンを、超伝導体を使って再構成したようなものだ。かつてのコンピュータ素子をリバイバルして、量子コンピューティングという最先端のテクノロジーに使ったのである。

量子アニーリングでビットの質の向上と集積化を目指す

―NEC入社後は量子コンピュータの開発にずっと関わっていたのか?

カリフォルニア大学サンタバーバラ校のジョン・マルティネス研究室に2009年~2010年まで留学していたが、帰国後、2014年にはこの分野を離れた。

―その後は何をしていたのか。

しばらくは事業部と共同で、量子ドットを使った赤外線センサーの開発をしていた。実はその量子ドットは荒川泰彦先生のところで作っていただいていた。人工衛星から地球表面を観察するリモートセンシング向けに、高感度な赤外線センサーが必要で、それを人工衛星に搭載することを目指すプロジェクトなども手掛けた。

―量子アニーリングに携わるようになった経緯を教えてほしい。

前述のプロジェクトを手掛けていた頃に、パラメトリック発振器を使って量子アニーリングができるという理論の提案が、東芝の後藤隼人氏やカナダのシャーブルック大学などから立て続けに発表された。理論の論文なので具体的なシステムを必ずしも限定していないが、われわれの仕事も引用してくれていて、ジョセフソン接合を使ったパラメトリック発振器について言及されていた。

それを受けて、2016年か2017年だったと思うが、新しい注目技術を紹介するという研究所内イベントで、「以前われわれが開発したパラメトリック発振器を使って量子アニーリングマシンができるかもしれない」という話をした。フォーマルな発表会ではなく、ポスターセッション形式で興味ある人と自由に議論するようなイベントだった。

そのポスターセッションの場ではないのだが、その日のうちに研究所のトップの方とお話する機会があり「やってみなさい」と言われた。最初は小規模な調査研究から始めるつもりだった。しかし、社会的にも量子コンピュータに対する期待が急速に盛り上がり、国立研究開発法人 新エネルギー・産業技術総合開発機構(NEDO)の公募に応募して、本格的に量子アニーリングの研究をするという話になり、今に至っている。

―NEDOのプロジェクトでは何を目指しているのか。

超伝導量子ビットのビット数を増やして集積化すること、1ビットの質を上げていくこと、この両方をターゲットとしている。特に集積化では、チップ自体の開発はもちろんだが、どうやってチップに3次元配線をするかという集積化技術も研究している。

日本の遅れを取り戻すには、プレーヤーの数とオープンなディスカッションが鍵

―NECが量子コンピュータ開発に向けて改めて歩み出したわけだが、世界から見て少し遅れを取ってしまっている日本の現状についてはどう思うか。

1999年にNECは1ビット動作に成功した後、他のグループが成功するまでに数年かかっている。われわれは2003年に世界初の2ビット動作に成功した。その時点では日本が先頭を走っていたわけだ。ところが、だんだん追い付かれ、追い抜かれていった。

私が1年間、米国の研究室にいて感じたことは、効率主義が徹底しているということだ。達成したいビジョンが鮮明で、それにいかに最短で到達するかということを最優先する。

だから、その目標を達成するのに必ずしも必要ないことは、面白いと思ってもやらないという判断をする。無駄なリソースは絶対に使わない。ビジョンを達成するために必要なことを、研究室のポスドクや学生を使って着実に遂行する。そこはかなり徹底されていたような気がする。

―もう少し、国ないしは企業からの支援がほしいと言う研究者もいるが、そういう感覚はあるか。

お金の問題ももちろんあると思うが、私はそれが一番という気はしない。もっとプレーヤーがたくさんいて、それぞれの機関でアクティビティーがある状況で、かつ情報交換・競争・協力できるような環境があったら、違っていたような気がする。

米国は当時でさえ、ジョン・マルティネス研究室の他にも5つぐらい有力研究機関があって、割とオープンにディスカッションや協力しながらやっていたように思う。当時、日本では超伝導量子回路ハードウェアの大学の研究室が少なかった。もちろん予算の問題もなくはないと思うが、プレーヤーの数という側面が大きいと思う。

日本の量子分野の未来は、ハードウェアの重要性の再認識と、異業種間連携にかかっている

―今日の量子コンピュータにおいて、ご自身の研究がどのように応用されているのか。

量子ビットと結合した共振器に微弱なマイクロ波を照射し、量子ビットの状態を読む「分散読み出し」という方法が、現在の標準的な超伝導量子ビットの読み出し方法となっている。エラー訂正を実現するために、高い精度で単一試行の読み出しをしようと思うと、パラメトリック増幅器が必要となる。

ジョセフソンパラメトリック増幅器は1960年代に最初に開発されたかなり歴史のあるデバイスだ。当初ノイズ特性のよいものが得られなかったようだが、1980年代にかなり高性能なものが実現されている。しかし、その後20年間世の中に広まるということはなかった。その理由の一つは、どうしてもそれがないと困るという応用先がなかったからだと思う。

1999年に中村・蔡らによる超伝導量子ビットが誕生し、2000年代初頭からマイクロ波を使った量子ビットの読み出しという流れが出てきてきた。単一試行読み出し実現のために、パラメトリック増幅器を再開発する必要があると考えたのは、われわれも含め世界で3~4つのグループだった。コロラド大学のグループが最初に論文を出し、続いてわれわれが出した。われわれは磁束駆動型というそれまでと違うタイプだった点にオリジナリティーがあった。

―NECが作ろうとしている量子アニーリングマシンの特徴や強みは何か。

正直なところ、本当にいいものができるかどうかは、まだ分からない。もちろん可能性はあると思っているからやっている。

われわれが作りたい量子アニーリングマシンは、今、D-Waveや幾つかのグループでもやっているような磁束量子ビットを使ったアニーリングとは全く方式が違う。単に違うというだけではなくて、性能がよくなる、あるいは集積化しやすいという可能性があると思って取り組んでいる。

まだ本当にどれぐらいの性能が出るか、どこまで集積化できるかということは、それほど明確にはなっていない。

―何年後に社会実装するつもりか。

NECとしては2023年と言っているのだが、簡単ではない。

いろいろなやり方があるが、今よくいわれているのは古典アニーラーと量子アニーラーを組み合わせて、ハイブリッドでやる方法である。量子でやるものはそれほどスケールが大きくないかもしれないが、本当に必要なところだけに量子を使う。それほど変わらない部分は古典でやってビット数を稼ぐ。このように組み合わせて、うまく連携させるという方式だ。D-Waveなどもそうだ。

社会実装や実用化するというときに、フルに量子でやることは難しいかもしれない。われわれはベクトル型コンピュータを使った古典アニーリングマシンも開発しているので、そういうものと小規模に量子の部分を組み合わせて、何か価値を出していくというやり方もあると思っている。

―現在の課題は何か。

まず、量子ビットの質をいかに上げるかということだ。

また、1ビットの振る舞いもまだ理解できていないところがある。要するに、回路としてこう動作するためにはこのようにデバイス設計すればいいという指針が、まだそれほど確立できていない。もしかしたら、そこが一番の課題かもしれない。

さらに、いかに量子コヒーレンスを壊さずに集積化していくかということも重要課題である。そのためにわれわれはフリップチップ接続など、量子ビットのチップと配線のチップを分けて、ハイブリッドで接続するという技術にも取り組んでいる。それ自体は量子とは直接関係ない技術なのだが、重要性はどんどん増している。そういうものをもっと洗練していかないといけない。

―量子ICTフォーラムに入会した動機や期待は何か。

産学官の連携、特に企業間の連携につながるような取り組みを期待する。これから量子分野で企業が果たす役割はとても大きいはずだ。逆に、企業がそこを果たせないと、日本は益々衰退してしまう。

超伝導量子回路の分野では、20年間かけて物理としての量子の理解はかなり進み、今はエンジニアリングのほうに重心が移りつつある。3次元実装、質のいい量子ビットを作るためのプロセス技術、コンピュータアーキテクチャなど、総合力の勝負である。

そこで求められている個々のレイヤーの要素技術の多くは、日本の企業に強みがあると思う。NECにも昔3次元実装を手掛けていたエンジニアがいる。日本全体としてハードウェアの事業はかなり縮小されてしまったが、これから量子分野で必要となる技術を持ったエンジニアは、まだたくさんいるはずだ。

ただし、どうやってそういう人たちにリーチしたらいいのかということは、なかなか難しい。もちろん企業なので、直接収益に結び付かないことに人を出せと言っても難しい。経営層に、長期的な視点に立った開発の重要性や連携の必要性を説明していく必要がある。

―例えばどういう業種なのか。半導体関係のハードウェア系なのか、そうでない異業種というイメージなのか。

いろいろあると思う。半導体のプロセス技術の専門家から見れば、超伝導のプロセス技術はまだまだ初歩的に見えるのではないだろうか。

他には冷凍機の技術、マイクロ波のコネクターの技術、増幅器やミキサーといったアナログ回路の技術などもそうだろう。

また、コンピュータアーキテクチャもそうだ。理想的には、しっかりとコンピュータアーキテクチャの設計指針が決まっていて、そのために必要な技術を上位レイヤーからデバイスレイヤーへと落とし込んでいくべきだと思うが、おそらくまだそんなにはっきりとは決まっていない。そのあたり、今のコンピュータ開発の歴史には、多くの学ぶ点があるのではないかと思う。

私も全体をなかなか見渡すということはできていないのだが、日本の企業の中には関連技術がたくさんあると思う。

今度私は、国立研究開発法人 科学技術振興機構(JST)のムーンショットプログラムで超伝導ハードウェア開発のプログラムマネジャーをやらせていただくのだが、参加する十数機関の半分近くは、これまで量子計算とは直接関係なかった人たちだ。とてもいい技術があって、量子分野にも応用できるに違いないと思っている。そういう人たちをうまく巻き込んで、プロジェクト全体の競争力・技術力を高めていきたいと考えている。

量子ICTフォーラムには、このような連携を促進するハブのような役割を担ってもらえることを期待している。

超伝導量子回路は、正しく設計すれば確かにその通りに動作する。同時に、生半可な理解では、太刀打ちできないレベルに業界としては発展している。時間はかかるかもしれないが、きちんと深い理解をして前に進むことこそ、エンジニアリングの理想だと信じている。